Zeit meines Lebens habe ich als selbsternannter Datenmessie beinahe schon leidenschaftlich Datenhamsterei betrieben, aber gleichzeitig nie ausreichend viele Gedanken an Backups verschwendet. Wenn man das weiß, erkennt man, dass ich in der großen Datenverlust-Lotterie unverschämt viel Glück gehabt habe. Schlimmer noch, die sogenannten Single Points of Failure sind mit den Jahren immer größer geworden, angesichts immer umfassenderer Datengräber, besonders in den letzten paar Jahren. Von meinen ersten 3,5 Zoll 720 Kbyte DD-Disketten in den 80er Jahren, über 700 MB CDRs in den 90ern, den 4,7 GB DVDRs in den 00er Jahren, bis zu den heutigen 16 TB HDDs, habe ich alle verfügbaren Datenträger immer sehr gerne mit meiner Sammlung vollgeschrieben. Sammlung deshalb, weil ich in weiser Voraussicht und in schöner Regelmäßigkeit die Inhalte auf den schwächelnden, alternden Datenträgern der vergangenen Generationen auf neuere übertragen habe, und die Datenmenge so kontinuierlich anstieg, die ich als meinen ganz eigenen Schatz betrachtet habe. Zuletzt lag der gesamte Krempel von unzähligen Disketten, einer vierstelligen Anzahl von CDs, einer dreistelligen Anzahl von DVDs, und einem ganzen Stapel älterer Festplatten auf nur noch drei zentralen Datenträgern. Also Daten aus über 30 Jahren Computernutzung – und für diese hatte ich keine (echten) Backups.

Selbstverständlich wusste ich als computeraffiner Mensch schon immer um die große Bedeutung von Backups. Früh brachte mein Vater mir bei, dass man von wichtigen Original-Disketten erst einmal (mindestens) eine Sicherheitskopie macht, und dann ausschließlich diese verwendet. Beim Verstehen half mir auch die Tatsache, dass Disketten oftmals relativ schnell die Grätsche machten. Datenverlust erlebte ich daher häufig, aber es war eben immer nur eine einzelne Diskette betroffen und nicht etwa ein gigantisches Archiv, das Jahrzehnte umfasste. Im Jahr 1995 unternahmen wir gemeinsam eine große Archivierungsaktion, bei der wir hunderte unserer Atari ST-Disketten in tagelanger Kleinarbeit auf DAT-Bändern sicherten. Die Aktion war ein voller Erfolg, die Backups benötigten wir jedoch nie. Bald darauf dominierte der PC unseren Alltag und der Siegeszug der optischen Datenträger begann. Selbstgebrannte CDs, selbstgebrannte DVDs, randvolle Festplatten, bald lag das Zeug kreuz und quer im Kinderzimmer herum. Die ISDN-Flatrate und die darauf folgende heimische DSL-Leitung machten es leicht, immer verrücktere, noch unnötigere Dinge herunterzuladen und “wegzubrennen”. Mit Hilfe von Tools wie GetRight, Go!Zilla oder FlashGet musste ich mir nicht einmal Mühe geben. Nur wenige Mausklicks und komplette Seitenarchive fanden auf mysteriöse Weise den Weg auf meine Festplatte – der Download lief dann über Nacht. Ob ich diese Dateien jemals anschauen würde? Wahrscheinlich nicht, aber das war zweitrangig.

Disketten wurden auf CDs übertragen, CDs auf DVDs, DVDs auf kleine Festplatten, und kleinere Festplatten auf immer größere Festplatten. Und heute sitze ich auf einem schätzungsweise 12 TB großen Berg an Daten, wie Dagobert in seinem Geldspeicher. Der Ausfall nur einer einzelnen meiner drei zentralen HDDs würde den Verlust von mindestens 15 Jahren an gesammelten Daten bedeuten. Für mich ein Katastrophenszenario, um das ich mich wirklich kümmern musste. Im Jahr 2012, als ich endlich die nötigen finanziellen Mittel besaß, besorgte ich mir einen 15 TB Netzwerkspeicher. Mit Hilfe von Robocopy und einem Batchskript synchronisierte ich sporadisch eine Auswahl der wichtigsten Ordner auf das verschlüsselte Netzwerkverzeichnis. Dies funktionierte gut, doch der Katastrophenfall trat auch in den folgenden Jahren nie ein, weshalb ich zu selbstsicher und faul wurde und meine Bemühungen reduzierte. Endlich im Jahr 2018 konnte ich mich dazu überwinden, alle meine Festplatten vollständig mit VeraCrypt zu verschlüsseln. Nun wurden Backups jedoch sogar noch viel wichtiger, denn wenn die Live-Entschlüsselung mit VeraCrypt plötzlich nicht mehr funktionierte, wäre das gleichbedeutend mit einem Festplattenausfall.

Doch die Technik gab mir erstaunlicherweise keinen Grund zur Sorge. Nach vier Jahren täglichen Gebrauchs arbeitet die Verschlüsselung immer noch einwandfrei. Im Jahr 2020 sattelte ich auf Linux um, und so lösten “rsync” und “Grsync” das bewährte Robocopy ab, und Ext4 löste NTFS ab. Erneut überraschte mich die ausgereifte Technik positiv, denn rsync konnte mühelos die mit Robocopy erstellten Backups aufgreifen und erneuern. Seit dem Sommer 2022 habe ich radikal damit begonnen, eine vernünftige Ordnung in meinem Archiv zu etablieren, habe dazu alte Strukturen aufgebrochen. Dies schuf erneut ungewohnte Herausforderungen, denn trotz meiner schlimmen Unordnung in meinem Dateisystem wusste ich bisher von den meisten Dingen nach all den Jahren wo sie lagen. Nun habe ich zwar Ordnung ins Chaos gebracht, doch muss ich paradoxerweise vieles nun tatsächlich erst suchen. Mit Hilfe von Grsync habe ich mir außerdem Jobs erstellt, die zwei komplette Festplatten auf das NAS spiegeln. Erstmals in meinem Leben bin ich nun in der Situation, dass meine wichtigsten Datengräber vollständig ausfallen könnten, ohne dass ich spürbaren Datenverlust befürchten müsste.

Nicht nur, dass auf meinem NAS vollständige Kopien der Festplatten vorliegen, auch bieten die Paritätsinformationen des RAIDs eine weitere Stufe der Redundanz, denn selbst wenn im NAS eine der Festplatten ausfällt, können die Daten noch verlustfrei wiederhergestellt werden. Und hier hört die Geschichte noch nicht auf: Mir wurde klar, dass meine Wohnung der letzte verbliebene Single Point of Failure darstellte. Ein Wohnungsbrand, Diebstahl oder ähnliches könnte weiterhin alle meine Daten auf einen Schlag vernichten. Die Lösung hierfür ist ein sogenanntes Off-Site-Backup, also eine weitere Kopie an einem weiter entfernten Ort. Und so sicherte ich den vollständigen Inhalt des Netzwerkspeichers auf einer verschlüsselten externen Festplatte und gab sie in vertrauenswürdige Hände zwecks Lagerung für den Katastrophentag X, der hoffentlich nie kommen möge.

Endlich habe ich ausreichende Ausfallsicherheit um mich wirklich sicher zu fühlen. Wenn morgen eine Festplatte quietscht und klackert und nur noch Fehlermeldungen ausspuckt, dann muss mich das nicht mehr beunruhigen: Alles ist noch da. Und ich bin dankbar, dass ich von Ausfällen verschont geblieben bin, als meine Infrastruktur noch ziemlich fahrlässigen “Mut zur Lücke” bewies. Es hätte nämlich auch ganz anders ausgehen können. Da das Thema Backups nun für mich geklärt wäre, kann ich den nächsten offenen Punkt angehen: Das Datenarchiv systematisch durchsuchen, aufräumen und objektiv nutzlosen Müll löschen. Aber Löschen bzw. Wegwerfen ist bekanntlich etwas, das jeden Messie an seine absoluten Schmerzgrenzen bringt.

Wie sieht ein sicheres Passwort aus? Soll es eine scheinbar sinnlose Kolonne aus unzusammenhängenden Zeichen sein, die man dann sowieso auf einem Zettel hinterlegt, weil man auch nach dem fünften Mal Eintippen immer noch abschreiben muss? Oder doch besser etwas Lesbares, das man nach dem ersten Blick im Kopf hat und dann auch nicht mehr vergisst? Muss es Sonderzeichen, Ziffern und am besten Groß- und Kleinbuchstaben gemischt enthalten, oder reicht es vielleicht schon aus, wenn das Passwort nur lang genug ist? Das Feld der IT-Sicherheit ist ein ziemlich weites, und je mehr Experten man befragt, desto mehr Empfehlungen bekommt man.

Wie sieht ein sicheres Passwort aus? Soll es eine scheinbar sinnlose Kolonne aus unzusammenhängenden Zeichen sein, die man dann sowieso auf einem Zettel hinterlegt, weil man auch nach dem fünften Mal Eintippen immer noch abschreiben muss? Oder doch besser etwas Lesbares, das man nach dem ersten Blick im Kopf hat und dann auch nicht mehr vergisst? Muss es Sonderzeichen, Ziffern und am besten Groß- und Kleinbuchstaben gemischt enthalten, oder reicht es vielleicht schon aus, wenn das Passwort nur lang genug ist? Das Feld der IT-Sicherheit ist ein ziemlich weites, und je mehr Experten man befragt, desto mehr Empfehlungen bekommt man.

Ich bin reich! Also zumindest an Speicherplatz. Seit gestern Abend kann ich 15 Terabyte an Daten speichern. Zusätzlich selbstverständlich zu den 8,5 TB die mir an internen und externen magnetischen Speichermedien bisher schon zur Verfügung standen. „Wer braucht denn soviel Platz?“ werden die üblichen

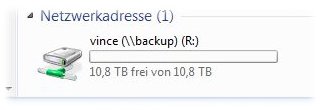

Ich bin reich! Also zumindest an Speicherplatz. Seit gestern Abend kann ich 15 Terabyte an Daten speichern. Zusätzlich selbstverständlich zu den 8,5 TB die mir an internen und externen magnetischen Speichermedien bisher schon zur Verfügung standen. „Wer braucht denn soviel Platz?“ werden die üblichen  Inzwischen habe ich Benutzer bzw. Freigabeverzeichnisse erstellt und diese schonmal probeweise unter Windows als Netzwerklaufwerke eingebunden und so die Rechtevergabe getestet. Scheint alles zu klappen, auch wenn ich dem Gerät meine Daten noch nicht so ganz anvertrauen will. Nachdem das NAS sich von seiner eigenen Software im Netzwerk nicht finden ließ, das Updaten der Firmware zuerst nicht klappen wollte, die Firmware zudem einen entsetzlich dämlichen Bug beim Anlegen der Benutzer hat (Artikel folgt wohl), mit der Datenträgersynchronisierung nach elf Stunden noch nicht ganz fertig war, und jetzt nach einem Reboot damit schlauerweise wieder von vorne anfängt, wobei die Synchronisierung stolze 50% der CPU frisst, bin ich zwiegespalten und etwas misstrauisch was das Ding angeht. Außerdem weiß ich nicht ob drei Minuten zum Hochfahren normal sind. Das packt meine Windows-Installation ja schneller und die müsste doch deutlich schwergewichtiger sein als so ein hochspezialisiertes Embedded-System. Vielleicht hätte ich mein Geld am Ende doch lieber dem Konkurrenzanbieter Synology geben sollen. Nunja, die Hauptsache ist, dass es läuft.

Inzwischen habe ich Benutzer bzw. Freigabeverzeichnisse erstellt und diese schonmal probeweise unter Windows als Netzwerklaufwerke eingebunden und so die Rechtevergabe getestet. Scheint alles zu klappen, auch wenn ich dem Gerät meine Daten noch nicht so ganz anvertrauen will. Nachdem das NAS sich von seiner eigenen Software im Netzwerk nicht finden ließ, das Updaten der Firmware zuerst nicht klappen wollte, die Firmware zudem einen entsetzlich dämlichen Bug beim Anlegen der Benutzer hat (Artikel folgt wohl), mit der Datenträgersynchronisierung nach elf Stunden noch nicht ganz fertig war, und jetzt nach einem Reboot damit schlauerweise wieder von vorne anfängt, wobei die Synchronisierung stolze 50% der CPU frisst, bin ich zwiegespalten und etwas misstrauisch was das Ding angeht. Außerdem weiß ich nicht ob drei Minuten zum Hochfahren normal sind. Das packt meine Windows-Installation ja schneller und die müsste doch deutlich schwergewichtiger sein als so ein hochspezialisiertes Embedded-System. Vielleicht hätte ich mein Geld am Ende doch lieber dem Konkurrenzanbieter Synology geben sollen. Nunja, die Hauptsache ist, dass es läuft.