Ach, ich habe die letzten Monate so wenige Beiträge geschrieben, dass ich jetzt der Meinung bin, das kompensieren zu müssen, indem ich über echt uninteressante Dinge aus meinem Leben berichte. Aber vielleicht gibt es ja jemanden, der dieselben Gedanken und Probleme wie ich hat. Also dann, kopfüber in das nächste Blog-Thema. In der heutigen Folge: Was ich mir zuletzt angeschafft habe und mein Erfahrungsbericht dazu.

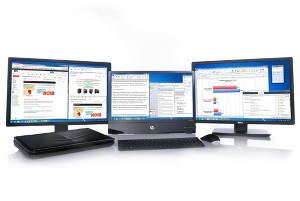

Ich bin ein Mensch, der am PC gerne sehr viele Fenster offen hat. Gleichzeitig! Damit ich alles im Blick haben kann. Das ist beispielsweise sinnvoll, wenn man ständig zwischen Instant Messenger, Dateibrowser, Webbrowser, E-Mail-Programm, Emulator, Texteditor, Entwicklungsumgebung und Grafikbearbeitungsprogramm hin- und herwechseln muss. Natürlich könnte ich auch in der Taskleiste immer umschalten, oder Alt+Tab bemühen (und das mache ich meistens auch so), aber es ist praktischer, wenn ich das erst gar nicht muss. Es ist eben viel komfortabler, wenn ich meine Arbeitsgeräte und Werkzeuge immer alle direkt griffbereit vor mir liegen habe, und nicht ständig in die untere Schublade greifen muss, um zwischen Stift und Schere zu wechseln.

Schon vor dreieinhalb Jahren habe ich mir privat erstmals eine Zwei-Monitor-Konfiguration aufgebaut, die mir völlig neue Möglichkeiten eröffnet hat. Damit kann man etwa mehrere Anwendungen auf verschiedene Monitore aufteilen, und selbst Vollbildanwendungen sind jetzt kein Grund mehr, nicht doch mehrere Programme im Blick zu behalten. Man könnte auf dem linken Monitor etwas im Vollbildmodus spielen, während auf dem rechten Monitor irgendeine Webseite mit hilfreichen Tipps geöffnet ist. Oder man könnte auf dem linken Monitor einen unglaublich wichtigen Artikel für einen bedeutenden Blog schreiben, während auf dem rechten Monitor gleichzeitig irgendein spannender Stream läuft. Und dann … öh … Oh, sorry, ich war gerade ein wenig abgelenkt. Naja, beim Arbeiten sollte man vielleicht doch besser für eine ablenkungsfreie Umgebung sorgen. Weniger ist da oft mehr. Aber in den meisten Fällen bin ich schon ganz glücklich damit, viel Desktopfläche zu haben.

Beim Thema Desktopfläche habe ich kürzlich wieder einen gewaltigen Sprung gemacht. Meine neueste technische Anschaffung ist ein Business-Monitor mit 28 Zoll Bilddiagonale, der den alten 27er nochmals leicht überbietet. Aber der wichtigste Punkt ist, dass es sich um einen UHD-Monitor mit der wahnwitzigen Auflösung von 3840×2160 handelt, ergo „4K“. Damit kann ich endlich 4K-Filmmaterial in nativer Auflösung bestaunen, ohne Skalierung. Mit dem neuen Monsterdisplay auf meinem Schreibtisch wurde dann leider mein alter, tapferer 24 Zoll-Monitor mit der 1920×1200-Auflösung in den Ruhestand geschickt. Neun Jahre lang hat das kleine Kerlchen alles mitgemacht, und selbst jetzt ist er noch gut in Form, obwohl er vor einigen Jahren auf einer Autofahrt einen dicken Kratzer auf der Mattscheibe abbekommen hat. Aber als Unterwegs-Monitor für kleine LAN-Partys bleibt er mir noch erhalten, denn dann spare ich mir das viele Ab- und Wiederaufbauen meiner Monitore.

Wo war ich? Achja… Wie ist das Leben mit so einer exorbitant hohen Desktopauflösung? Auf der einen Seite schon echt klasse, weil man damit wirklich viel Raum für alle seine Fenster hat. Man muss bedenken, der Monitor hat genug Platz für vier Full-HD-Videos, in jeder Ecke eins. Auf der anderen Seite ist es jedoch nicht immer ganz einfach. Ich sollte zumindest kurz auf den größten Nachteil eingehen: Es ist alles verdammt klein. Ich schätze mal, ein 28 Zoll-Monitor ist wirklich die absolute Untergrenze, ab der 4K funktioniert. Manchmal ertappe ich mich dabei, wie ich mit den Augen näher zum Bildschirm gehe, um kleine Texte entziffern zu können. Man gewöhnt sich aber recht schnell an die Mini-Bildschirmelemente, muss beim Klicken ein wenig besser zielen und auch mehr mit der Maus rudern, vor allem wenn man von der linken Kante des linken Monitors bis zur rechten Kante des rechten Monitors fahren will. Das sind bei mir zusammen immerhin 6400 Pixel Breite.

Aber das ist alles noch kein großes Problem. Bislang normalgroße Schriften sind neuerdings eben kleine Schriften. Und bei den kleinen Schriften muss man ab jetzt genauer hingucken. Natürlich kann man das Betriebssystem auch so einstellen, dass es alle Fensterelemente, Icons und Texte automatisch hochskaliert – aber wozu dann überhaupt 4K? Dann hätte ich einfach bei meinem alten Monitor bleiben können und noch eine Menge Geld gespart. Natürlich will ich den neu gewonnenen Platz auch nutzen, und nicht gleich dadurch wieder vergeuden, indem ich alles auf dem Bildschirm größer mache. Bilddateien, die mir noch vor 15 Jahren bequem als Windows-Wallpaper dienlich waren, sind mit dem neuen Monitor nur noch unwesentlich mehr als Thumbnails. Der einsame Browser im abgebildeten Screenshot ist übrigens schon geringfügig größer als Full-HD.

Meine größte Sorge vor meiner Anschaffung war ursprünglich: Packt meine Grafikkarte überhaupt 4K-Auflösung? Ein wenig Recherche in Internetforen und zu den Grafikkarten-Spezifikationen diverser älterer Modelle hat mir Zuversicht gegeben, und tatsächlich war meine Sorge eher unbegründet, denn in den allermeisten Fällen lautet die Antwort: Ja! 4K-Desktopauflösung ist für eine halbwegs moderne Grafikkarte selbst im Low-Budget-Bereich kein großes Kunststück, sogar Onboard-Grafikchips kriegen das längst mühelos hin. Meine Grafikkarte steuert auch gerne zwei Monitore mit 4K-Auflösung an, wenn man möchte. Einfach per HDMI, DVI oder DisplayPort anschließen und los gehts. Ob man damit Spiele in 4K-Auflösung spielen sollte, ist natürlich eine gänzlich andere Frage. In den allermeisten Fällen ist das weniger empfehlenswert, außer man besitzt eine teure Gaming-Grafikkarte. Aber kann man jedes Spiel immer auch in einer niedrigeren Auflösung rendern.

Wie sieht das denn mit tollem UHD-Filmmaterial aus? Kriegt man da wenigstens ordentlich was fürs Auge geboten? Ja und nein. Zum einen muss ich gestehen, dass ein 28 Zoll-Monitor wahrscheinlich nicht unbedingt ideal ist, um Filme in so hoher Auflösung qualitativ ausreichend zu beurteilen. Kurzgesagt, in schnellen Action-Sequenzen in denen sich relativ viel bewegt, hat Ultra-HD-Material praktisch keinen wahrnehmbaren Vorteil gegenüber Full-HD, schon gar nicht wenn man sich einfach nur auf den Film konzentriert. Seine größte Stärke spielt 4K z.B. bei Nahaufnahmen von Gesichtern aus, wenn man genug Zeit hat, sich die vielen winzigen Details anzusehen und darüber zu staunen. Aber das sind eigentlich Ausnahmen. In den meisten Fällen dürfte es Durchschnittsmenschen ohne ausgeprägtes Qualitätsempfinden oder Technikwissen schwerfallen, zu erkennen, ob sie gerade einen UHD-Film sehen oder nicht, zumal sehr viele UHD-Filme auf dem Markt entweder ohnehin Upscale-Mogelpackungen sind, oder ältere Filme generell mehr durch ultrawinzigen Filmgrain bestechen als durch echte, sichtbare, ultrahohe Bildqualität.

Für mich ist der erwartete Wow-Effekt leider ausgeblieben. Nicht, dass es ein Fehlkauf gewesen wäre, aber ein wenig mehr erwartet habe ich dann doch. Man könnte nun, wie gesagt, betonen, dass 28 Zoll keine geeignete Grundlage sind, um das richtig zu beurteilen, aber dafür sitze ich am Monitor eben auch sehr viel näher dran als am 50 Zoll Fernseher, den ich immer nur von der entfernten Couch im Blick habe. Im Prinzip sollte sich das also irgendwo ausgleichen. Aber es bleibt mir in jedem Fall ein Monitor mit einer gigantischen Desktopfläche, die ich mit Fenstern zuklatschen kann. Jetzt habe ich sogar soviel davon, dass ich die Hälfte davon als Werbefläche vermieten könnte. Oh Moment, das machen Webseiten ja schon lange so.