Vor etwas mehr als einem Jahr, als ich mir mein NAS mit 15 TB Bruttospeicherplatz leistete und als Backuplösung für die Ewigkeit an meinen Arbeitsplatz stellte, musste ich mich im Freundes- und Bekanntenkreis mit dem berüchtigten „Wer braucht denn soviel Platz?“-Troll rumärgern, dem ich damals am liebsten bei jeder Begegnung eine verpassen wollte, aber mittlerweile ignoriere ich das nach Möglichkeit einfach. Ihr wisst schon, dieses widerliche Exemplar von Troll, das bei jeder Diskussion über Festplattenkapazitäten jenseits der 500 GB aus seinem Versteck kriecht und auf seine trollhaft charmante Art deren Existenzberechtigung in Frage stellt, nur weil er oder sie damit nichts anzufangen weiß, und sich daher nicht vorstellen kann, dass überhaupt irgendjemand etwas damit anfangen könnte. Ich versuche erst gar nicht zu erklären, wie das dann aussieht, wenn man mal 15 TB Speicher in die Diskussion einbringt. In solchen Sphären werden sogar Informatiker manchmal zu solchen Trolls, obwohl sie es besser wissen sollten. Ein Studium erzeugt Fachbildung, aber eben nicht zwangsläufig Intelligenz.

Seit Monaten spiegele ich also fleißig meine Festplatten in mehr oder weniger regelmäßigen Abständen auf mein NAS und bin äußerst zufrieden damit. Bis jetzt ist der Ernstfall zwar noch nicht eingetreten, dass ich auf ein Backup zurückgreifen musste, aber Vorsicht ist besser als Nachsicht. In der Zwischenzeit gingen die missgünstigen Unkenrufe der Neider und Ignoranten etwas zurück, doch inzwischen habe ich es mit einer neuen, deutlich aggressiveren Troll-Mutation zu tun bekommen, die sich erneut durch unqualifizierte Kommentare in Bezug auf Festplatten verrät. Meine bisher recht zahlreichen Begegnungen mit dieser unbelehrbaren Spezies, die offenbar Technikscheuklappen trägt, verliefen immer sehr unerfreulich für mich, daher werde ich mir wohl eine neue Dimension der Gelassenheit gegenüber Dummgeschwätz aneignen müssen.

Hier nun also einige Variationen der Äußerungen dieser Kreaturen, mit denen sie versuchen ihr getrolltes Opfer durch eine Kombination von Unwissen und gefährlichem Halbwissen zur Weißglut zu bringen. Im Gegensatz zur inzwischen womöglich fast ausgestorbenen Form der Festplattentrolle beziehen diese sich immer auf die neue Technologie der wesentlich schnelleren SSD-Festplatten, denn nun sprechen sie den herkömmlichen magnetisch-mechanischen Festplatten ihre komplette Daseinsberechtigung ab. Schlimmer noch, sie verachten jeden, der es wagt, sich heute noch gewöhnliche Festplattentechnik ins Haus zu holen. Das klingt dann vom Sinn etwa folgendermaßen:

„Warum wird mit allen Mitteln versucht diese alte Technologie am Leben zu erhalten?“

„Was sind das für Fortschrittsbremser, die sich noch normale Festplatten kaufen, wo es doch schon lange SSD gibt?“

„Warum wird diese völlig veraltete Technik noch gebaut? Wieso forscht daran überhaupt noch jemand, das bringt doch nichts!“

Man sollte Preise für die dämlichsten Sprüche vergeben, die man so im Netz findet. Womöglich stünden die Chancen nicht schlecht, dass einer dieser hirnverbrannten SSD-Trolle einen gewinnt. Nun, warum sollte man heutzutage noch gewöhnliche Festplatten kaufen? Zugegeben, die SSDs sind sehr viel schneller, in der Zugriffszeit unschlagbar, mangels mechanischer Bauteile (drehende Scheiben, bewegliche Schreib- und Leseköpfe) unempfindlich gegenüber Erschütterungen, und sie sind wirklich sehr leicht. Aber sie haben zwei gigantische Nachteile, die in meinem Fall den Geschwindigkeitsvorteil nicht aufwiegen können: Sie sind (immer noch) extrem teuer (bezogen auf den Preis pro GB), und ihre Festplattenkapazitäten sind eher ein schlechter Scherz.

Die teuersten SSDs können ein Terabyte an Daten aufnehmen, wohingegen ihre mechanischen Konterparts es schon lange auf die vierfache Menge bringen. Das Wachstum bei der Kapazität ist zwar inzwischen stagniert, aber solange SSDs nicht mindestens ebenso gut als Datengrab taugen und ähnlich günstig zu haben sind … nein Sir, solange sind SSDs noch kein vollwertiger Ersatz für normale Festplatten. Wenn ich sehr viel Wert auf Geschwindigkeit lege, dann kann ich mich mit dem höheren Preis und der deutlich niedrigeren Kapazität womöglich abfinden. Aber da ich Festplatten in erster Linie zwecks Storage kaufe, also um dort große Datenmengen abzulegen, kann ich niemandem guten Gewissens zustimmen, der meint, es gäbe keinen Grund mehr, sich noch normale Festplatten zu kaufen. Wer sowas behauptet, sollte vielleicht doch mal einen Blick über den Tellerrand werfen.

Toll sind auch die Versuche, meine Argumentation zu entkräften, indem mir vorgehalten wird, ich hätte wohl einfach selbst noch keine SSD erlebt, sonst würde ich nicht so an der veralteten „Schrott-Technik“ festhalten. Richtig ist, dass ich tatsächlich noch keine SSD verwende. Allerdings bin ich sehr wohl in der Lage, mir vorzustellen wie schnell der Rechner damit wird. Es ist sicherlich sehr praktisch, wenn der Rechner immer sofort reagiert und jede Anwendung innerhalb von Sekundenbruchteilen geladen und einsatzbereit ist. Und das Betriebssystem erst – „8 Sekunden!“, heißt es immer. Super! Ich freue mich darauf! Sobald es 4 TB SSDs für 300 Euro gibt, gerne. Vorher vermutlich nicht. Was ich mir allerdings sehr wohl überlegen könnte, wäre ein Mischkonfiguration mit SSD fürs Betriebssystem und normalen HDDs für mein persönliches Datenarchiv.

Die SSD-Trolle glauben wohl, dass Firmen in ihren Rechenzentren/SANs auch nur noch SSDs verbauen, weil es ja die neueste und damit deutlich bessere Technologie ist. Falsch! Fakt ist, niemand verwendet SSDs im Serverbereich, um darauf große Datenmengen abzulegen. Das wäre wirtschaftlicher Unfug. SSDs werden höchstens dort verwendet, wo Geschwindigkeit eine sehr große Rolle spielt. Aber selbst da unterschätzen die SSD-Trolle wie schnell so ein HDD-RAID werden kann, wenn man ihn auf Geschwindigkeit auslegt.

Es gibt doch inzwischen Elektroautos. Welche Fortschrittsbremser sind das eigentlich, die sich noch gewöhnliche Luftverpester-Benziner und Dreckschleuder-Diesel kaufen? Oh wait, ich habe ja selbst ein Auto mit Ottomotor. Total veraltete Technik, wer würde sowas brauchen? Strom kommt aus der Steckdose! Ich denke, ich habe meinen Standpunkt klargemacht. Lasst mich in Ruhe und kauft euch eure SSDs. Ich kann damit warten, bis ich echten Bedarf daran habe.

Die ganze Welt bestaunt gerade die Wii U von Nintendo, und mich interessiert es nicht die Bohne. Dafür habe ich zum Thema Nintendo etwas anderes im Sinn.

Die ganze Welt bestaunt gerade die Wii U von Nintendo, und mich interessiert es nicht die Bohne. Dafür habe ich zum Thema Nintendo etwas anderes im Sinn.

Android kann einem wirklich Angst machen. Als ich heute im Büro kurz einen Blick auf mein Smartphone warf, traf mich beinahe der Schlag. Erschrocken sah ich, dass alle meine gespeicherten Memos (mit teilweise recht persönlichem Inhalt) in eine große SMS eingefügt und aus dem Adressbuch eine Person aus einem weiter entfernten Freundeskreis ausgewählt worden war. Es hat nur noch ein versehentliches Berühren des „Senden“-Buttons gefehlt und ich hätte eine ganze Stange von SMS (für mehrere Euro) verschickt, und noch dazu gefüllt mit privaten Dingen, die wirklich niemanden etwas angehen.

Android kann einem wirklich Angst machen. Als ich heute im Büro kurz einen Blick auf mein Smartphone warf, traf mich beinahe der Schlag. Erschrocken sah ich, dass alle meine gespeicherten Memos (mit teilweise recht persönlichem Inhalt) in eine große SMS eingefügt und aus dem Adressbuch eine Person aus einem weiter entfernten Freundeskreis ausgewählt worden war. Es hat nur noch ein versehentliches Berühren des „Senden“-Buttons gefehlt und ich hätte eine ganze Stange von SMS (für mehrere Euro) verschickt, und noch dazu gefüllt mit privaten Dingen, die wirklich niemanden etwas angehen.

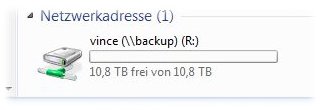

Ich bin reich! Also zumindest an Speicherplatz. Seit gestern Abend kann ich 15 Terabyte an Daten speichern. Zusätzlich selbstverständlich zu den 8,5 TB die mir an internen und externen magnetischen Speichermedien bisher schon zur Verfügung standen. „Wer braucht denn soviel Platz?“ werden die üblichen

Ich bin reich! Also zumindest an Speicherplatz. Seit gestern Abend kann ich 15 Terabyte an Daten speichern. Zusätzlich selbstverständlich zu den 8,5 TB die mir an internen und externen magnetischen Speichermedien bisher schon zur Verfügung standen. „Wer braucht denn soviel Platz?“ werden die üblichen  Inzwischen habe ich Benutzer bzw. Freigabeverzeichnisse erstellt und diese schonmal probeweise unter Windows als Netzwerklaufwerke eingebunden und so die Rechtevergabe getestet. Scheint alles zu klappen, auch wenn ich dem Gerät meine Daten noch nicht so ganz anvertrauen will. Nachdem das NAS sich von seiner eigenen Software im Netzwerk nicht finden ließ, das Updaten der Firmware zuerst nicht klappen wollte, die Firmware zudem einen entsetzlich dämlichen Bug beim Anlegen der Benutzer hat (Artikel folgt wohl), mit der Datenträgersynchronisierung nach elf Stunden noch nicht ganz fertig war, und jetzt nach einem Reboot damit schlauerweise wieder von vorne anfängt, wobei die Synchronisierung stolze 50% der CPU frisst, bin ich zwiegespalten und etwas misstrauisch was das Ding angeht. Außerdem weiß ich nicht ob drei Minuten zum Hochfahren normal sind. Das packt meine Windows-Installation ja schneller und die müsste doch deutlich schwergewichtiger sein als so ein hochspezialisiertes Embedded-System. Vielleicht hätte ich mein Geld am Ende doch lieber dem Konkurrenzanbieter Synology geben sollen. Nunja, die Hauptsache ist, dass es läuft.

Inzwischen habe ich Benutzer bzw. Freigabeverzeichnisse erstellt und diese schonmal probeweise unter Windows als Netzwerklaufwerke eingebunden und so die Rechtevergabe getestet. Scheint alles zu klappen, auch wenn ich dem Gerät meine Daten noch nicht so ganz anvertrauen will. Nachdem das NAS sich von seiner eigenen Software im Netzwerk nicht finden ließ, das Updaten der Firmware zuerst nicht klappen wollte, die Firmware zudem einen entsetzlich dämlichen Bug beim Anlegen der Benutzer hat (Artikel folgt wohl), mit der Datenträgersynchronisierung nach elf Stunden noch nicht ganz fertig war, und jetzt nach einem Reboot damit schlauerweise wieder von vorne anfängt, wobei die Synchronisierung stolze 50% der CPU frisst, bin ich zwiegespalten und etwas misstrauisch was das Ding angeht. Außerdem weiß ich nicht ob drei Minuten zum Hochfahren normal sind. Das packt meine Windows-Installation ja schneller und die müsste doch deutlich schwergewichtiger sein als so ein hochspezialisiertes Embedded-System. Vielleicht hätte ich mein Geld am Ende doch lieber dem Konkurrenzanbieter Synology geben sollen. Nunja, die Hauptsache ist, dass es läuft.